Sumilla. I. Inteligencia artificial (AI) en el sistema de administración de Justicia en América Latina. II. Inteligencia artificial (AI) para la emisión de medidas de protección en los casos de violencia por razón de género contra las mujeres. III. A modo de conclusión. IV. Fuentes bibliográficas.

I. Inteligencia Artificial (AI) en el sistema de administración de Justicia en América Latina.

El uso de la «inteligencia artificial» en el sistema de administración de justicia avanza en distintas Regiones del mundo. En América Latina, dan buena cuenta de ello, entre otros, (i) Prometea, un sistema que aplica inteligencia artificial para preparar automáticamente dictámenes judiciales, desarrollado en 2017 por la Fiscalía de la Ciudad de Buenos Aires (Estévez et al., 2020); (ii) PretorIA, un proyecto de inteligencia artificial que busca hacer más eficiente el proceso de selección de los casos de tutela judicial de derechos fundamentales, a partir de los cuales la Corte Constitucional de Colombia fija su jurisprudencia (Saavedra y Upegui, 2021); y (iii) Synapses, un sistema configurado para trabajar con el proceso judicial electrónico, desarrollado por el Departamento de Tecnología del Consejo Nacional de Justicia de Brasil y el Tribunal de Justicia de Rondonia (CAF- Banco de desarrollo de América Latina y el Caribe, 2022).

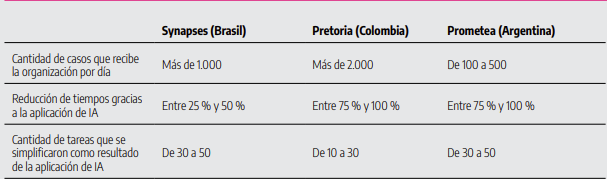

Prometea, PretorIA y Synapses, son sistemas complejos de uso «inteligencia artificial» que posibilitan la interoperabilidad de datos, la automatización de procesos, y la predicción de la solución de un caso. Fueron implementados con un objetivo claro: lograr la optimización del sistema de administración de justicia mediante la agilización de los procesos judiciales para la atención oportuna de los derechos de la ciudadanía (Sánchez, 2022; CAF- Banco de desarrollo de América Latina y el Caribe, 2022). A la luz de los resultados positivos: reducción de los tiempos en la tramitación de los procesos judiciales y la simplificación de tareas (ver cuadro 1), varios países han anunciado su implementación en el sistema de justicia, en general, y en la atención de problemáticas concretas como la violencia por razón contra las mujeres, catalogada –por su gravedad y magnitud– como la pandemia «la pandemia en la sombra» (ONU Mujeres,2020).

Fuente: Elaborado por CAF- Banco de desarrollo de América Latina y el Caribe, 2022[1]

II. Inteligencia Artificial (AI) para la emisión de medidas de protección en los casos de violencia por razón de género contra las mujeres.

Tras el éxito de Prometea, PretorIA y Synapses, países como Argentina y Perú han anunciado la suscripción de acuerdos marco y/o desarrollo de proyectos para de aplicación de «inteligencia artificial» en la emisión de medidas de protección en los casos de violencia por razón de género contra las mujeres. En el Perú, la Presidencia de la Corte Superior de Justicia de Lima Norte, anunció en junio de 2023 que, en coordinación con la Gerencia General del Poder Judicial y la Universidad Nacional de Ingeniería (UNI), está desarrollando «Amauta Pro». Un sistema que aplica un algoritmo que permitirá la clasificación del tipo de la violencia –leve, moderado, severo o muy severo– y coadyuvará a la emisión de mejores medidas de protección (El Peruano, 2023). El uso de la «inteligencia artificial» para atención de este grave problema no es nuevo. Ya hace más de una década y media que España implementó un programa automatizado de valoración de riesgo, a través del denominado «Sistema VioGén».

«VioGén», es un sistema de seguimiento integral de los casos de violencia por razón de género contra las mujeres, de la Secretaría de Estado de Seguridad del Ministerio del Interior de España[2], fue creado el 26 de julio de 2007, en cumplimiento de lo dispuesto por la Ley Orgánica 1/2004, de 28 de diciembre, «de medidas de protección integral contra la violencia de género». Se trata, en esencia, de un sistema de evaluación policial del riesgo de reincidencia en casos de violencia de género que se fundamenta sobre una aplicación informática, que ha incorporado funcionalidades basadas en inteligencia artificial (Estévez, 2020).

El funcionamiento de VioGén es aparentemente sencillo: cuando se produce la denuncia –que puede ser presentada por la víctima, un familiar, un testigo o un agente de la policía– se da de alta de manera inmediata en el «Sistema VioGén», y los agentes que realizan las diligencias efectúan una valoración del riesgo por medio de los formularios de VPR (Valoración Policial del Riesgo) y VPER (Valoración Policial de la Evolución del Riesgo). A partir de los resultados conjuntos de las preguntas y la investigación policial, el «sistema», determina si, en un caso concreto, se presenta uno de los cinco niveles de riesgo: no apreciado, bajo, medio, alto y extremo. Cada uno de ellos conlleva medidas de protección específicas. Por ello, se considera que el «Sistema VioGén» va más allá de la mera valoración del riesgo, ya que conlleva la activación y puesta en práctica de una serie de medidas de protección policial, tasadas y proporcionadas a cada nivel de riesgo resultante (González Álvarez, et al. 2018).

El Ministerio de Igualdad de España, en el Boletín estadístico de octubre de 2023[3], publicado conjuntamente con la Secretaría de Estado de Igualdad y contra la violencia de género, y la Delegación del Gobierno contra la violencia de género, precisa que el «Sistema VioGén», pretende alcanzar los siguientes objetivos:

- Aglutinar a las diferentes instituciones públicas que tienen competencias en materia de violencia de género.

- Integrar toda la información de interés que se estime necesaria

- Realizar valoraciones policiales del riesgo

- Atendiendo al nivel de riesgo, realizar seguimiento y protección a las víctimas en todo el territorio nacional.

- Proporcionar a la víctima un “Plan de Seguridad Personalizado” con medidas de autoprotección.

- Efectuar una labor preventiva, emitiendo “Notificaciones Automatizadas”, cuando se detecte alguna incidencia o acontecimiento que pueda poner en peligro la integridad de la víctima.

Busca, en definitiva, establecer una tupida red que permita el seguimiento y protección de forma rápida, integral y efectiva de las mujeres maltratadas, y de los menores que de ella dependan, en cualquier parte del territorio del Estado de España.

Las bases teóricas, características, instrumentos y resultados del Protocolo de Valoración Policial del Riesgo, una de las funcionalidades del «Sistema VioGén», desarrollado tras más una década de aplicación y más de tres millones de valoraciones policiales del riesgo realizadas, es analizada y expuesta al detalle, en el libro publicado por el Instituto de Ciencias Forenses y de la Seguridad, de la Universidad de Autónoma de Madrid (2018), bajo el sugerente título La valoración policial del riesgo de violencia contra la mujer pareja en España- Sistema Vio Gén[4]. En este breve artículo, me gustaría destacar dos aspectos precisados en esta obra. En primer lugar, que una de las funcionalidades principales del «Sistema VioGén» es la posibilidad de realizar valoraciones del riesgo de violencia contra la mujer, mediante los formularios de VPR y VPER que clasifican los casos con cinco niveles de riesgo de reincidencia. La utilización de dos formularios de valoración de riesgo distingue este procedimiento español de valoración del riesgo del resto de protocolos conocidos en el mundo, que solo utilizan uno.

En segundo lugar, que los formularios españoles, de corte más actuarial que de juicio clínico, empleados en el marco del «Sistema VioGén» cuentan con una fórmula automática de corrección que pretende reducir la subjetividad de los evaluadores que lo utilizan. No obstante, la estimación del riesgo no descansa en una mera máquina, sino que el «Sistema» permite que los agentes policiales, que son los que mejor conocen los casos por haberlos investigado en profundidad, puedan corregir el resultado automático del protocolo de valoración de riesgo cuando cuenten con información que así lo aconseje. De modo que, «Sistema VioGén», es una herramienta desarrollada para facilitar el trabajo diario a los agentes. Pues, al final de cada valoración policial de riesgo el «Sistema VioGén», resume las respuestas señaladas y pregunta por la conformidad del agente con el resultado automático, permitiendo que el usuario manifieste su desacuerdo y asigne el nivel de riesgo que él considera más apropiado, facilitando sus razones, permitiendo así el perfeccionamiento del Sistema.

En efecto, fuentes oficiales, y especialistas en la materia coinciden en sostener que el margen de mejora –y, en consecuencia, también el margen de error– del «Sistema VioGén» reside en el componente humano, por lo que es imprescindible que los agentes tengan siempre más y mejor formación y sensibilidad sobre la violencia por razón de género contra las mujeres (El país, 2022). Abona esta idea la sentencia –emitida por la Sección Quinta de lo Contencioso-Administrativo de la Audiencia Nacional, que resolvió el recurso contencioso administrativo 2187/2019– que condena a la Guardia Civil perteneciente al Ministerio del Interior de España, al pago de una indemnización ascendente a € 180, 000 (ciento ochenta mil euros), por error en la valoración del riego de violencia de género, de una mujer asesinada en manos de su esposo, tras haber solicitado una orden de protección que le fue denegada por la Guardia Civil (Estévez, 2020).

III. A modo de conclusión

Richard Susskind, en «Tribunales on line y la justicia del futuro (2020)» afirma que la transformación tecnológica en los tribunales y servicios judiciales es inevitable, y que para 2030, y posiblemente mucho antes, los tribunales de justicia del mundo se habrán transformado totalmente gracias a la tecnología. En efecto, es inevitable y, además, imprescindible que el sistema de administración de justicia incorpore las tecnologías basadas en inteligencia artificial (AI), pues estas herramientas podrían contribuir a solucionar problemas acuciantes como la sobrecarga procesal, el acceso a la justicia, y también coadyuvar en la lucha contra la violencia por razón de género contra las mujeres, en concreto, en la emisión de medidas de protección expeditivas y eficaces –valoración de riego–, y en el sistema de seguimiento como se hace en España hace aproximadamente dos décadas. No obstante, se debe enfatizar que se trata de herramientas, cuyo diseño y aplicación depende de los seres humanos. El desafío es, por tanto, en relación con el tema que nos ocupa, conseguir que los programas (algoritmos) y su aplicación estén libres de sesgos y estereotipos de género. En ese sentido, es importante tener en cuenta las directrices establecidas por la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura, en el primer marco normativo universal sobre ética en la AI, la «Recomendación sobre la ética de la inteligencia artificial», adoptada por 193 Estados miembros de la UNESCO en 2021:

“Los Estados Miembros deberían velar por que se optimice plenamente el potencial de las tecnologías digitales y la inteligencia artificial para contribuir a lograr la igualdad de género, y han de asegurarse de que no se conculquen los derechos humanos y las libertades fundamentales de las niñas y las mujeres, ni su seguridad e integridad, en ninguna etapa del ciclo de vida de los sistemas de IA. Además, la evaluación del impacto ético debería incluir una perspectiva transversal de género”.

En suma, las tecnologías basadas en la inteligencia artificial (AI) ofrecen oportunidades importantes, pero deben desarrollarse respetando la ética y los derechos humanos, sobre todo –de manera reforzada– de las personas en situación de vulnerabilidad, a fin de evitar que la AI se convierta en un factor que agrave la enorme disparidad imperante en América Latina, el continente más desigual del planeta. Ello supone, entre otros aspectos, adoptar un enfoque inclusivo para garantizar que los beneficios de las tecnologías de la inteligencia artificial estén disponibles y sean accesibles para todas y todos, teniendo en consideración las necesidades específicas de los diferentes grupos de edad, los sistemas culturales, los diferentes grupos lingüísticos, las personas con discapacidad, las niñas, las mujeres y las personas vulnerables o en situación de vulnerabilidad. ¡La tarea, es ardua!

IV. Referencias bibliográficas

CAF- Banco de desarrollo de América Latina y el Caribe (2022) Uso estratégico de datos e inteligencia artificial, Informe 6. Disponible en: https://scioteca.caf.com/bitstream/handle/123456789/1932/Uso%20estrat%C3%A9gico%20de%20datos%20e%20inteligencia%20artificial%20en%20la%20justicia.pdf?sequence=4&isAllowed=y

El País (9 de abril de 2022) VioGén: visita a las tripas del algoritmo que calcula el riesgo que una mujer sufra violencia machista. Disponible en: https://elpais.com/tecnologia/2022-04-10/viogen-visita-a-las-tripas-del-algoritmo-que-calcula-el-riesgo-de-que-una-mujer-sufra-violencia-machista.html

El Peruano (8 de junio de 2023). Sistema con inteligencia artificial permitirá a jueces resolver solo casos de violencia severa o muy severa. Disponible en: https://www.elperuano.pe/noticia/214889-sistema-con-inteligencia-artificial-permitira-a-jueces-resolver-solo-casos-de-violencia-severo-o-muy-severo

Estévez Mendoza, L. M. (2020) Inteligencia artificial y violencia contra las mujeres: ¿funcionan los sistemas automatizados de evaluación del riesgo?, Perspectivas. Revista de ciencias jurídicas y políticas, núm. 127, pp. 127-141.

Estévez, E., Linares. S., Fillottrani (2020) Prometea. Transformando la administración de justicia con herramientas de inteligencia artificial, Banco Interamericano de Desarrollo. Disponible en: https://publications.iadb.org/es/prometea-transformando-la-administracion-de-justicia-con-herramientas-de-inteligencia-artificial

González Álvarez, J. L., López Osorio, J. J., Muñoz Riva, M. (2018) La valoración policial del riesgo de violencia contra la mujer pareja en España-Sistema VioGén, Instituto de Ciencias florenses y de la Seguridad- Universidad Autónoma de Madrid. Disponible en: https://www.uma.es/media/files/valoracion_policial_riesgo_violencia_mujer.pdf

La Vanguardia (19 de mayo de 2019). Algoritmos contra la violencia machista. Disponible en: https://www.lavanguardia.com/tecnologia/20190519/462147339117/algoritmos-violencia-machista.html

Ministerio del Interior. (06 de enero, 2023). Sistema VioGén. https://www.interior.gob.es/opencms/ca/servicios-al-ciudadano/violencia-contra-la-mujer/sistema-viogen/

ONU Mujeres (2020). Violencia contra las mujeres: la pandemia en la sombra, 6 de abril, https://www.unwomen.org/es/news/stories/2020/4/statement-ed-phumzile-violence-againstwomen-during-pandemic#notes

Saavedra V. y Upegui J.C. (2021). Informe. Colombia PretorIA y la automatización del procesamiento de causas de derechos humanos, Derechos digitales América Latina – Dejusticia. Disponible en: https://www.derechosdigitales.org/wp-content/uploads/CPC_informe_Colombia.pdf

Sánchez Acevedo, M. E. (2022) La inteligencia artificial en el sector público y su límite respecto de los derechos fundamentales, Estudios Constitucionales, núm. 2, pp. 257-284.

UNESCO (2022) Recomendación general sobre la ética de la inteligencia artificial. Disponible en: https://www.unesco.org/es/articles/recomendacion-sobre-la-etica-de-la-inteligencia-artificial

[1] Informe disponible en: https://scioteca.caf.com/bitstream/handle/123456789/1932/Uso%20estrat%C3%A9gico%20de%20datos%20e%20inteligencia%20artificial%20en%20la%20justicia.pdf?sequence=4&isAllowed=y

[2] https://www.interior.gob.es/opencms/ca/servicios-al-ciudadano/violencia-contra-la-mujer/sistema-viogen/

[3] https://violenciagenero.igualdad.gob.es/violenciaEnCifras/boletines/boletinMensual/2023/docs/BEM_Octubre_2023.pdf

[4] https://www.uma.es/media/files/valoracion_policial_riesgo_violencia_mujer.pdf

![El «control de una economía o mercado ilegal» comprende también el control del aparato de justicia y de los servicios que este presta, pues dicho control puede traducirse en poder y, adicionalmente, en beneficios económicos (Ley 32108) [Apelación 423-2025, Nacional, f. j. 4]](https://img.lpderecho.pe/wp-content/uploads/2025/10/MAZO-JUEZ-SENTENCIA-PENAL-LPDERECHO-218x150.jpg)

![No toda investigación abierta precisa de la declaración del secreto de la investigación; esta medida se sujeta a un analisis de proporcionalidad y por un plazo prudencial [Casación 1621-2025, Penal Especial, f. j. 9]](https://img.lpderecho.pe/wp-content/uploads/2025/10/MAZO-LIBRO-JUEZ-LEY-LPDERECHO-218x150.jpg)

![Dado que el derecho penal se caracteriza por ser personalísimo, la persecución penal contra una persona concluye con su fallecimiento [Casación 1099-2023, Lambayeque, f. j. 3]](https://img.lpderecho.pe/wp-content/uploads/2025/07/JUEZ-FIRMANDO-DOCUMENTO-LPDERECHO-218x150.jpg)

![Usurpación: la restitución del bien solo alcanza las áreas especificadas en la acusación; el juez no puede extender su decisión sobre espacios que no han sido objeto de imputación ni de debate en el proceso [Casación 774-2022, La Libertad]](https://img.lpderecho.pe/wp-content/uploads/2024/03/post-banner-casa-desalojo-vivienda-posesion-civil-bien-construccion-mala-fe-LPDerecho-218x150.jpg)

![Ley Orgánica del Registro Nacional de Identificación y Estado Civil (Ley 26497) [actualizada 2025]](https://img.lpderecho.pe/wp-content/uploads/2025/05/Ley-organica-del-registro-nacional-de-identificacion-y-estado-civil1-LPDERECHO-218x150.jpg)

![Suspenden plazos procesales y administrativos en estos órganos jurisdiccionales y administrativos [RA 000031-2026-CE-PJ]](https://img.lpderecho.pe/wp-content/uploads/2024/03/placio-de-justicia-pj-poder-judicial-fachada-LPDerecho-218x150.jpg)

![TC: Sentencia que declara infundada demanda de inconstitucionalidad sobre prescripción de deudas tributarias [STC 0004-2019-PI] fachada del TC con logo de LP](https://img.lpderecho.pe/wp-content/uploads/2020/09/Empresas-deberan-padar-deudas-tributarias-TC-rechaza-demanda-de-incosntitucionalidad-STC-0004-2019-PI-218x150.jpg)

![La acreditación de la experiencia en la ejecución de obras como requisito de calificación en el marco de un procedimiento de selección, así como, aquella que se presenta ante el RNP debe regirse, cada una por las reglas que le son propias, incluyendo las restricciones que resulten aplicables [Opinión D000009-2026-OECE-DTN]](https://img.lpderecho.pe/wp-content/uploads/2025/10/OECE-FACHADA-LPDERECHO-218x150.jpg)

![TUO del Reglamento General de los Registros Públicos (Resolución 126-2012-Sunarp-SN) [actualizado 2026]](https://img.lpderecho.pe/wp-content/uploads/2026/02/TUO-del-Reglamento-general-registros-publicos-LPDerecho-218x150.png)

![Decreto Legislativo del Notariado (Decreto Legislativo 1049) [actualizado 2026]](https://img.lpderecho.pe/wp-content/uploads/2026/02/BANNER-REGLAMENTO-NOTARIAL2-218x150.jpg)

![Código de Responsabilidad Penal de Adolescentes [actualizado 2026]](https://img.lpderecho.pe/wp-content/uploads/2024/08/CODIGO-DE-RESPONSABILIDAD-PENAL-DE-ADOLESCENTES-DECRETO-LEGISLATIVO-1348-ACTU-LPDERECHO-218x150.jpg)

![Ley de Delitos Informáticos (Ley 30096) [actualizada]](https://img.lpderecho.pe/wp-content/uploads/2024/08/ley-de-delitos-informaticos-ley-30096-actualizada-LPDERECHO-218x150.jpg)

![[VÍDEO] ¿Quieres postular a la Fiscalía? Estas son las preguntas que hacen en las entrevistas](https://img.lpderecho.pe/wp-content/uploads/2021/10/postular-fiscalia-preguntas-entrevista-LP-218x150.jpg)

![Dina Boluarte: Trabajadores de confianza pueden tener un periodo de prueba más extenso y no tienen derecho a indemnización vacacional [Casación 37905-2022, Lima]](https://img.lpderecho.pe/wp-content/uploads/2024/04/RENIEC-DINA-BOLUARTE-LPDerecho-324x160.jpg)

![Cesan por límite de edad a jueza suprema Mariem Vicky De La Rosa Bedriñana [RA 000016-2026-P-CE-PJ]](https://img.lpderecho.pe/wp-content/uploads/2026/02/Mariem-Vicky-de-la-Rosa-LPDerecho-100x70.jpg)

![Código Penal peruano [actualizado 2026]](https://img.lpderecho.pe/wp-content/uploads/2024/05/VENTA-CODIGO-PENAL-LPDERECHO-100x70.jpg)

![Nombre del año 2026: Año de la Esperanza y el Fortalecimiento de la Democracia [Decreto Supremo 011-2026-PCM]](https://img.lpderecho.pe/wp-content/uploads/2022/12/palacio-gobierno-1-LPDerecho-100x70.png)

![El «control de una economía o mercado ilegal» comprende también el control del aparato de justicia y de los servicios que este presta, pues dicho control puede traducirse en poder y, adicionalmente, en beneficios económicos (Ley 32108) [Apelación 423-2025, Nacional, f. j. 4]](https://img.lpderecho.pe/wp-content/uploads/2025/10/MAZO-JUEZ-SENTENCIA-PENAL-LPDERECHO-100x70.jpg)

![Dina Boluarte: Trabajadores de confianza pueden tener un periodo de prueba más extenso y no tienen derecho a indemnización vacacional [Casación 37905-2022, Lima]](https://img.lpderecho.pe/wp-content/uploads/2024/04/RENIEC-DINA-BOLUARTE-LPDerecho-100x70.jpg)